Por dentro da corrida pela inteligência artificial na bolsa

O ChatGPT é só a ponta da disputa alucinante das big techs e startups pela dianteira no mercado de IA. Nos bastidores, a Nvidia (NVDC34) é a maior vencedora dessa rinha. Entenda o setor mais hypado de 2023.

m 5 de abril de 1993, três engenheiros de computação tomavam café em uma espelunca de beira de estrada chamada Denny’s, a alguns quilômetros da cidade californiana de San José. Ao trio, não faltava neurônio nem currículo. O taiwanês Jensen Huang já havia projetado microprocessadores na AMD, a maior concorrente da Intel. Curtis Priem fazia chips na IBM. E Chris Malachowsky trabalhava na Sun Microsystems, criadora da linguagem de programação Java.

Naquele ano, adolescentes de classe média mundo afora viviam a Antiguidade Clássica dos videogames, com Mega Drive, Super NES e Game Boy. Curtis, Chris e Jensen perceberam que essa indústria, nos próximos anos, iria gerar uma demanda maciça por algo que as empresas em que eles trabalhavam não forneciam: hardware projetado para gerar gráficos cada vez mais realistas. O salto de Super Mario World (1990) para Counter-Strike (2000), por exemplo, foi brutal, e rodar jogos com visual 3D se tornou uma tarefa pesada para os PCs do tempo da internet discada. Prevendo o fenômeno, a trinca de nerds decidiu correr na frente das big techs da época.

Foi no balcão do Denny’s que eles fundaram a Nvidia, a empresa que criou o conceito de unidade de processamento gráfico (GPU). O primeiro produto desse tipo foi a GeForce 256, de 1999, uma placa de vídeo que dava um gás no desempenho de jogos de desktop. No mesmo ano, o empreendimento virou gente grande e fez seu IPO. Não havia concorrentes: Xbox? Usava Nvidia. Playstation 3? Também Nvidia.

Mas esse era só o começo. Logo, os cientistas da computação perceberam que as GPUs não são úteis só para gerar as explosões do GTA ou os reflexos na lataria dos carros do Gran Turismo. A arquitetura paralela dessas placas de vídeo, pensada para realizar várias tarefas simultaneamente, é ideal para minerar criptomoedas e treinar algoritmos de deep learning – o ramo da inteligência artificial (IA) que deu origem a ferramentas como o ChatGPT.

O segredo é que as GPUs têm milhares de processadores – os tais núcleos, ou cores –, contra os quatro, oito ou dezesseis de uma CPU comum. E cada núcleo é capaz de realizar suas computações à revelia dos outros. Isso torna tudo (muito) mais rápido, e permite rodar IAs baseadas em redes neurais, que são inspiradas na arquitetura descentralizada do cérebro humano, com neurônios interconectados.

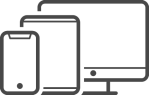

O chip V100 da Nvidia se tornou, por uma distância esmagadora, o hardware mais usado em pesquisas na área: até 2022, havia aparecido em 6.612 artigos científicos sobre IA. As três próximas posições depois do V100 no ranking, com mais de 2 mil usos cada uma, também são ocupadas por chips da Nvidia. Para comparar: existe um pequeno grupo de startups que tenta concorrer no design desses componentes, e a mais popular delas, a Graphcore, só conseguiu emplacar 69 artigos. Os chips da Nvidia são usados 90 vezes mais do que os chips de startups somados, e 78 vezes mais que as TPUs do Google (a resposta da empresa à supremacia das GPUs).

O peso da nuvem

Comprar suas próprias placas Nvidia sai caro. Por isso, empresas que oferecem apps movidos a IA usam algo entre 20% e 40% de sua receita para pagar as três grandes nuvens – Amazon Web Services (AWS), Google Cloud Platform (GCP) e o Microsoft Azure – por um tempinho nas GPUs delas. Dar os primeiros passos é ainda mais difícil: startups que estão criando suas IAs do zero usam entre 80% e 90% da grana que conseguem nos primeiros rounds de investimento para alugar hardware da Nvidia via nuvem.

Isso transforma as big techs em reféns. De acordo com o relatório State of AI de 2022, a Meta usa 16 mil placas A100 da Nvidia, mais modernas que a V100, para os seus próprios desenvolvedores, e oferece 5,4 mil ao público externo. A Tesla tem 7,3 mil. No Brasil, Vale e Petrobras são clientes da empresa; a petroleira tem um supercomputador chamado Pégaso com 2.016 placas A100.

Não se sabem os números exatos de cada big tech, mas é só fazer as contas: estima-se que Microsoft, Google e Amazon invistam US$ 100 bilhões por ano em equipamento e infraestrutura. E em 2022, a receita da Nvidia oriunda de vendas de GPUs para datacenters foi de aproximadamente US$ 15 bilhões. Hoje, a empresa arrecada anualmente com chips para IA uma cifra superior ao valor de mercado de suas três maiores concorrentes somadas.

A febre da IA veio em boa hora, já que o público gamer da empresa decepcionou no pós-pandemia – natural, já que as pessoas não estão mais trancadas jogando em desktops, e que a mineração caseira de cripto foi para as cucuias com escândalos como o da FTX. As receitas oriundas do setor caíram 46% do 4T21 para o 4T22.

É uma má notícia, mas não machuca o monopólio sutil que a Nvidia construiu. Por exemplo: quando um programador trabalha com IA, ele escreve os códigos usando algo chamado framework, como o PyTorch (que é uma cria da Meta) ou o TensorFlow (Google). Esses frameworks precisam conversar com as placas de vídeo. Por isso, existe uma camada de software intermediária, chamada API, que a Nvidia fornece na forma de um produto chamado Cuda.

A Cuda aproveita ao máximo a arquitetura paralela das GPUs, distribuindo as tarefas entre os núcleos. Existem alternativas de código aberto, como o OpenCL, mas elas não são tão populares. A Cuda se tornou uma trincheira contra a concorrência e oferece, por ora, os recursos favoritos de quem trabalha com deep learning. “Você tem muito mais facilidade de programar em cima da Nvidia que qualquer outra placa”, diz Fernando Osório, professor da USP de São Carlos e membro do Centro para Inteligência Artificial (C4AI), uma parceria da USP com IBM e Fapesp. “Quem sabe programar TPU do Google? Pouca gente.”

Resultado: as ações da Nvidia sobem 175% em 2023. Num único pregão, em 25 de maio, os papéis chegaram a cravar 24% de alta – algo assombroso para uma companhia que já estava entre as dez mais valiosas dos Estados Unidos. A razão do frenesi foi a previsão de vendas para o 2T23, anunciada pela empresa: US$ 11 bilhões, em grande parte oriundos do setor de datacenters. Isso representaria uma alta de 83% em relação aos US$ 6,5 bilhões de receita líquida do 2T22.

Alguns dias mais tarde, o valor somado de todas as ações da Nvidia chegou a US$ 1 trilhão – marca que só cinco companhias tinhma alcançado na história. Isso coloca a fabricante de GPUs na posição de quarta maior empresa dos EUA em valor de mercado, atrás apenas de Apple, Microsoft e Amazon (o Google caiu para quinta posição). Na bolsa brasileira, as BDRs da Nvidia (NVDC34) entraram para o clube das mais negociadas.

Rinha de startups

Em 2017, um grupo de funcionários do Google apresentou, em um artigo científico, um modelo de inteligência artificial chamado transformer. Ele analisa as palavras considerando todo o contexto em que elas aparecem, como um ser humano faz. Além disso, ele é capaz de hierarquizar o quão importante cada palavra do texto é em relação às demais.

Por exemplo: na frase “Michael Scott é uma pessoa-chave na empresa Dunder Mifflin”, a palavra “pessoa” é imprescindível para que se entenda o significado de “chave”, já que não estamos falando de um objeto metálico.

Essa é a inovação central por trás do ChatGPT, o chatbot da OpenAI que viralizou a partir de novembro de 2022, com financiamento de US$ 10 bilhões da Microsoft. O Google ficou em alerta. Afinal, foram eles que criaram as IAs transformers e desenvolveram o Bert, um dos primeiros modelos de processamento de linguagem natural (NLP) baseado nelas, em 2018. Ser ultrapassado pela Microsoft, que é sinônimo de Windows no imaginário popular, não pegou bem. E o ChatGPT é uma ameaça ao serviço de busca, já que responde diretamente às dúvidas dos usuários, sem redirecioná-los a outros sites.

Pensando nisso, o CEO Sundai Pichar já está correndo atrás do prejuízo com o robô Bard, baseado no modelo LaMDA, que é o equivalente Google do GPT. Mas a bolsa tem tolerância zero: um erro de informação do Bard em seu vídeo de lançamento, em fevereiro, fez as ações da Alphabet caírem 9%.

O fato é que temos um pega-pra-capar nesse mercado. Dos oito cientistas que assinaram o artigo pivotal de 2017, sete já deixaram o Google para trabalhar em startups recém-nascidas, como a Anthropic, a Co:here e a Character.ai. Essas empresas estão construindo seus próprios LLMs (sigla de large language models, ou “grandes modelos de linguagem”) com desempenho próximo ao do ChatGPT.

As big techs não querem se resignar à posição de provedoras de nuvem, e estão fechando parcerias à moda da Microsoft com a OpenAI: a Amazon se aliou à Anthropic, bem como o Google, que também fechou com a Co:here – para não falar em sua subsidiária DeepMind, que fez a primeira IA capaz de vencer um humano no jogo Go, o AlphaGo.

As gigantes não podem ficar paradas porque, no fim do dia, placas da Nvidia são placas da Nvidia. Você pode rodar sua IA na nuvem de qualquer big tech – quem cobrar menos leva. Isso gera um problema de fidelização da clientela. Mas é claro que, por ora, esse playground é para poucos. A capacidade de processamento necessária para realizar experimentos em larga escala na área de IA aumentou 300 mil vezes em dez anos, o que garante a dianteira para quem oferece força bruta.

Para a firma de venture capital A16z, do Vale do Silício, tanto as big techs como as iniciantes do setor estão em um momento pivotal para imaginar modelos de negócio rentáveis. Elas precisam descobrir se suas IAs são mais lucrativas como produtos isolados ou incorporadas como recursos a serviços já bem-estabelecidos (por exemplo, um gerador de imagens embutido no Adobe Photoshop, ou um assistente de texto como extensão do Chrome).

Elas também têm o desafio de se diferenciar da concorrência em um cenário disputado, em que os modelos de machine learning que geram textos, imagens, códigos e até moléculas para a indústria farmacêutica ainda são todos razoavelmente parecidos, e muitas empresas duplicam os resultados de suas competidoras em meses.

A concorrência é massiva. Só o Brasil tinha 702 startups de IA em 2021, de acordo com um levantamento da plataforma Distrito. Nos EUA, fala-se em 14 mil. Ninguém dorme no ponto. Exemplificando com um único setor: em 2022, já havia 18 remédios criados com auxílio de IA em testes clínicos. Eram zero em 2020.

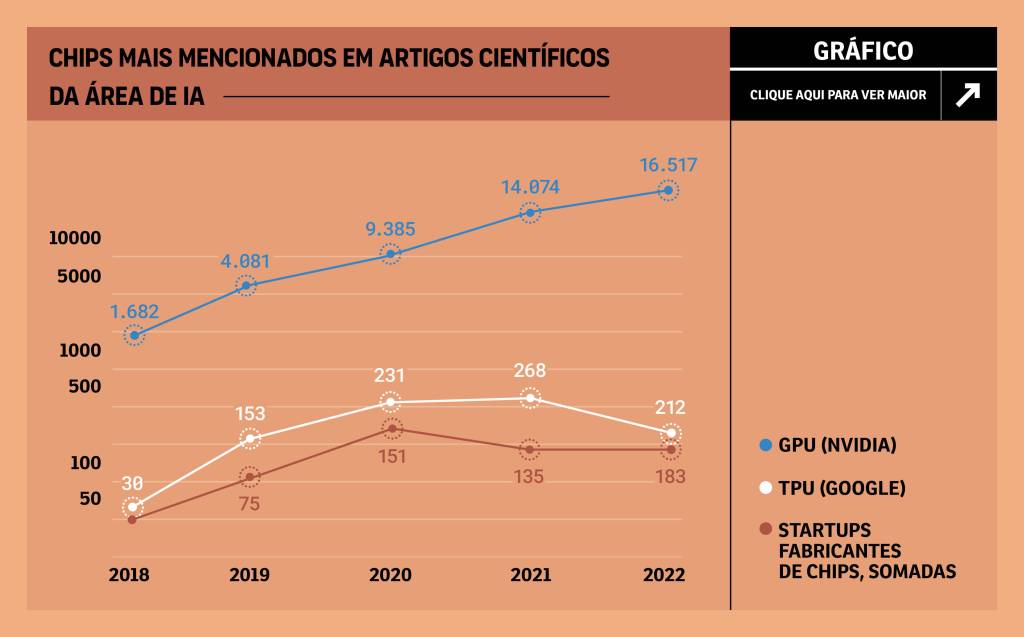

Enquanto isso, a fonte de dólares do venture capital sofreu um contratempo. Com os juros em alta Ocidente afora para combater a inflação, investidores que normalmente apostariam em empresas ousadas transferiram sua grana para ativos ultrasseguros. O mais recente relatório State of AI estima que o capital de risco destinado a startups de IA, mundo afora, tenha caído de US$ 111,4 bi em 2021 para US$ 70,9 bi em 2022 (o gráfico à esquerda, que para em US$ 58 bi, vai só até outubro, que era o último mês para o qual havia dados disponíveis). A queda nos aportes acelera o processo de seleção natural das empresas.

Por outro lado, o dinheiro pode vir de fontes inesperadas: a Otan, por exemplo, tem um fundo de 1 bilhão de euros para investir em tecnologias de uso dual (que servem tanto para civis como para militares). IA, naturalmente, está nesse balaio. É o primeiro fundo de venture capital soberano multinacional, com 22 nações participantes. Os mais idealistas do setor, claro, têm um pé atrás com a indústria militar.

Essa está longe de ser a única questão ética em jogo. O ChatGPT foi alimentado com conteúdo de milhões de redatores e jornalistas – conteúdo que, com frequência, está atrás de paywalls. O mesmo vale para os bots geradores de imagens: a Getty, um banco de fotos que atende veículos de imprensa e produtores de conteúdo, está processando o Stable Diffusion. É que o treinamento da IA usou, gratuitamente, milhões de fotos deles. Limitações legais como essa podem cortar as asas de negócios que, hoje, têm potencial.

No fim, o exercício de futurologia quase sempre erra: o mercado ainda é muito jovem para qualquer aposta segura. A única certeza é que, por ora, a Nvidia e os datacenters são os alicerces em que o setor se apoia, e o vertedouro final do dinheiro de quem aposta nele, seja via ações, seja via venture capital.

“As pequenas diferenças entre as startups vão se acentuando. Algumas vão engolindo outras e crescem. Saem daí as grandes empresas”, diz Fábio Cozman, professor da Escola Politécnica da USP e diretor do C4AI. “Em 2000, teve o boom da internet, havia mil empresas aparecendo. Eu trabalhava nos EUA na época e ouvi uma pessoa falar que uma certa startup não daria certo, porque não cobrava pelo serviço.” Essa empresa era o Google.

Calendário Bolsa Família de dezembro 2025: veja datas de pagamento

Calendário Bolsa Família de dezembro 2025: veja datas de pagamento Nova isenção do IR: entenda como ela impacta sua renda

Nova isenção do IR: entenda como ela impacta sua renda Governo restringe antecipação de saque-aniversário do FGTS

Governo restringe antecipação de saque-aniversário do FGTS 1ª parcela do décimo terceiro é adiantada para 28 de novembro; saiba mais

1ª parcela do décimo terceiro é adiantada para 28 de novembro; saiba mais USP fecha parceria com o Google e cria cátedra especializada em inteligência artificial

USP fecha parceria com o Google e cria cátedra especializada em inteligência artificial